Ab 2026 bringt der EU AI Act verbindliche Regeln für den Umgang mit Künstlicher Intelligenz. Besonders betroffen: Kundencenter, in denen Chatbots und Sprachassistenten Standardanfragen automatisieren. Diese Systeme gelten als «limited risk», erfordern aber klare Transparenzpflichten und die Möglichkeit, jederzeit einen Menschen einzuschalten. Für Hochrisikobereiche wie Finanzen oder Gesundheit gelten strenge Auflagen mit Dokumentations- und Überwachungspflichten. Unternehmen müssen ihre KI-Strategien jetzt prüfen und Prozesse anpassen, um den neuen Vorgaben zu entsprechen.

Mit dem AI Act, dem Gesetz zur Künstlichen Intelligenz, versucht die EU vor allem, die Verbreitung von Falschinformationen unter Strafe zu stellen. Allerdings sind auch Kundencenter von dem Gesetz betroffen. Denn Chatbots und andere Systeme, bei denen KI eingesetzt wird, fallen unter die Regelungen. «In Anbetracht der breiten Anwendungsbereiche von KI nimmt der AI Act jegliche Akteure entlang der Wertschöpfungskette in Verantwortung, wenn auch mit unterschiedlichem Maß», erklärte die IHK München.

Seit 2024 gibt es das Gesetz, das unterschiedliche Risiken als Grundlage für Maßnahmen zum Schutz der Verbraucher vorsieht. Noch befindet man sich in einer Übergangsphase, das Gesetz soll am 2. August 2026 in Kraft treten. Betroffen sind nicht nur Unternehmen, die in der EU ansässig sind, sondern auch solche, die mit Kunden in der EU Geschäfte machen oder KI-Systeme in der EU anbieten – darunter fallen auch Kundencenter, selbst wenn sie nicht physisch in der EU sitzen.

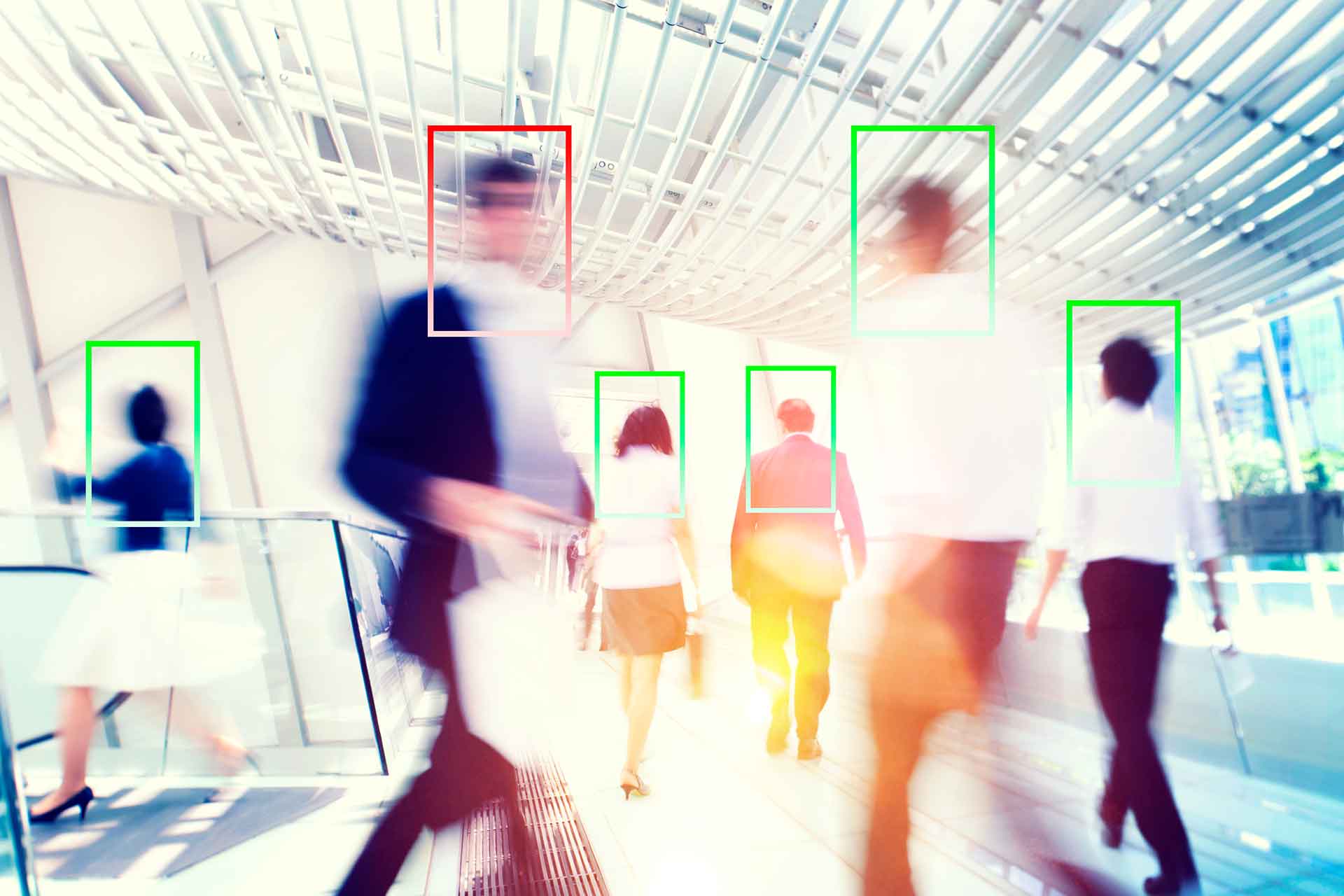

Der EU-KI-Act unterscheidet vier Risikostufen: minimales Risiko, begrenztes Risiko, hohes Risiko und verbotenes Risiko. Die meisten KI-Systeme, die im Kundenservice eingesetzt werden – wie etwa Chatbots, die einfache Fragen beantworten oder Bestellungen entgegennehmen – fallen in die Kategorie «begrenztes Risiko».

Menschliche Kontrolle gefordert

Die Regulierungsbehörden wollen zum Beispiel sicherstellen, dass es eine menschliche Kontrolle gibt. Nutzer müssen darauf aufmerksam gemacht werden, wann und wie KI zum Einsatz kommt. Ist das nicht der Fall, können drakonische Strafen drohen. Es genügt auch nicht, den KI-Einsatz lediglich in den Allgemeinen Geschäftsbedingungen zu erwähnen. Nach den Vorstellungen der EU muss einem Kunden im Chat per Text- oder Sprachnachricht deutlich gemacht werden, wenn er mit einer KI kommuniziert.

Jonathan Bernwieser von EU-Startups beschreibt weitere Konsequenzen. Sobald Kundenrechte betroffen sind oder wichtige Daten erfasst oder verändert werden, muss es die Möglichkeit geben, dass ein menschlicher Mitarbeiter hinzugezogen werden kann. Solche Einschränkungen bedeuten letztlich, dass eine Vollautomatisierung der Kundencenter in weite Ferne rückt.

Wie wahrscheinlich diese Entwicklung ist, sei aber dahingestellt. Immer mehr Unternehmen treten bei der KI-Expansion auf die Bremse und analysieren die bisherige Nutzung. So hat zum Beispiel Klarna eingesehen, dass man auf menschliche Mitarbeiter nicht verzichten kann.

Standardanfragen sind meistens «limited risk»

Das EU-Gesetz erlaubt jedoch weiterhin, was in den meisten Kundencentern schon Realität ist: die Automatisierung von Standardanfragen wie nach Preisen, Produktinformationen und Ähnlichem.

Die meisten dieser Anfragen sind als «limited risk», also «eingeschränktes Risiko», eingestuft. Das hebt aber die Pflicht zur Transparenz nicht auf: Kunden müssen selbst bei Bagatellanfragen über den Einsatz von KI informiert werden und jederzeit einen menschlichen Mitarbeiter verlangen können.

Für manche Branchen gibt es verschärfte Regeln, wenn das Risiko besonders hoch ist. Das betrifft etwa den Finanzsektor, insbesondere wenn es um Kredite geht, oder den Gesundheitssektor, wenn es um die Übermittlung privater Daten geht. Dann werden ausführliche Risikoanalysen, technische Dokumentationen und eine dauerhafte menschliche Überwachung notwendig.

Der AI Act überschneidet sich damit auch mit der EU-Datenschutzverordnung. Diese bleibt weiterhin in Kraft. Auch Anbieter außerhalb der EU unterliegen ihr, wenn sie in der EU tätig sind. Kritisch kann es an einem Punkt werden: So schreibt der AI Act beispielsweise eine Dokumentation von Chats vor – diese muss aber zugleich mit den Vorschriften der DSGVO übereinstimmen.

Das sollten Unternehmen beachten:

Unternehmen sollten spätestens jetzt ihre Prozesse und den Einsatz von KI analysieren und eine Risikoanalyse vornehmen. Je tiefer die Integration von KI in den Ablauf von Kundenkontakten geht, desto größer ist das Risiko – und der Aufwand, den Vorschriften der EU zu genügen.

Unternehmen, die KI einsetzen, sollten deshalb folgende Checkliste beachten:

- Sind Funktionen eingebaut, die Kunden auf die Verwendung eines KI-Agenten hinweisen? (z. B.: «Hallo, ich bin ein virtueller Mitarbeiter.»)

- Gibt es eine einfache und klar hervorgehobene Möglichkeit, einen menschlichen Mitarbeiter zu kontaktieren?

- Sind synthetische Stimmen oder KI-generierte Inhalte als solche gekennzeichnet?

- Gibt es eine dokumentierte Beschreibung des KI-Systems?

- Wie werden Chats gespeichert?

- Gibt es Feedback-Kanäle für Kunden zum KI-Einsatz?

- Wird die DSGVO auch beim KI-Einsatz beachtet?

- Folgen auch Partner den Vorgaben?

Der letzte Punkt ist wichtig, weil sich der AI Act auf alle Teile der Wertschöpfungskette bezieht. Wer also einen externen KI-Chat einkauft, muss sich dennoch an die EU-Vorgaben halten und seine Lieferanten darauf hinweisen.

Das Future of Life Institute hat auf seiner Webseite zu dem Gesetz einen kleinen Check für Unternehmen veröffentlicht, mit dem sie zumindest eine erste Einschätzung bekommen, wie stark sie betroffen sind: EU AI Act Compliance Checker

Empfohlen ist aber in jedem Fall auch eine Rechtsberatung. Auf der Webseite kann man zum Beispiel eingeben, welche Art von Unternehmen man hat (Entwickler, Hersteller, Großhändler usw.), welche Ausrüstung benutzt wird und ob man unter die Hochrisikogruppen fällt, etwa weil man im Bereich Biometrie, in der kritischen Infrastruktur oder im Bildungswesen tätig ist.

Wie bei den meisten Seiten zu diesem Thema ist auch diese in Behördensprache geschrieben. Sie sollte aber zumindest den Einstieg in die Thematik erleichtern, um den Bedarf an rechtlicher Unterstützung einschätzen zu können. Man kann sich auch ein Flowchart herunterladen, in dem die Risikoanalyse grafisch dargestellt ist.

Der komplette Text des Gesetzes mit dem Titel Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on artificial intelligence and amending Regulations kann auf der Webseite der EU heruntergeladen werden: EU AI Act Volltext.

Thomas Wanhoff

Thomas Wanhoff, Jahrgang 1966, ist ein deutscher Journalist und Autor. Er arbeitete bei Zeitungen wie der “Frankfurter Neuen Presse”, war Produktentwickler bei der “Welt” und schreibt für die Nachrichtenplattform t-online. Außerdem betätigt er sich als freier Autor, mit Schwerpunkten auf CRM und Personalentwicklung. Wanhoff lebt seit 2007 in Südostasien.